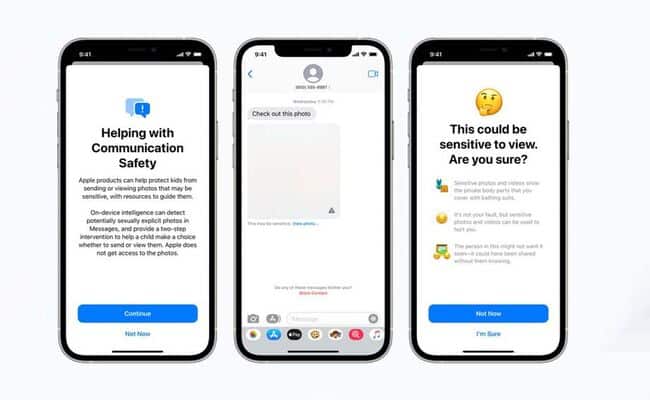

يضيف أحدث إصدار تجريبي من iOS 15.2 من Apple ميزة أمان الاتصال إلى تطبيق الرسائل.

تم تصميم Communication Security لحماية الأطفال من الصور غير اللائقة عن طريق مسح الصور الواردة والصادرة بحثًا عن مواد جنسية صريحة.

يتم تعتيم أي صور تطابق هذا الوصف ، ويتم تحذير الطفل بشأن محتواها ويقال إنه لا بأس في عدم رؤيتها.

تم تصميم الميزة ، المرتبطة بالمشاركة العائلية الحالية من Apple ، لتوفير الموارد للأطفال المتأثرين حتى يتمكنوا من الحصول على المساعدة.

يحتوي الإصدار المميز الذي تم إصداره في أحدث إصدار تجريبي من iOS 15.2 على اختلاف جوهري واحد عما أعلنته الشركة في الأصل في أغسطس ، حيث لن ترسل إشعارات إلى الآباء إذا قرر الطفل عرض صورة جنسية صريحة.

في شكلها الأصلي ، يمكن أن تقدم الميزة مشكلات تتعلق بالسلامة عندما يكون أحد الوالدين عنيفًا أو مسيئًا.

بدلاً من ذلك ، يتوفر للأطفال خيار إخطار شخص يثقون به بشأن صورة مميزة ، وهذا الخيار منفصل عن خيار حظر الصورة وعرضها.

يتم إجراء عمليات التحقق عبر الجهاز ، ولا تؤثر على التشفير التام بين الأطراف. لا يترك الجهاز أي مؤشر على اكتشاف عُري. الشركة ليس لديها حق الوصول إلى الرسائل.

تم الإعلان عن ميزة “أمان الاتصالات” في الأصل في أغسطس كجزء من ثلاث ميزات مصممة لحماية الأطفال من الاعتداء الجنسي.

ومع ذلك ، قالت الشركة إنها تؤجل تقديم الميزات في الشهر التالي استجابة للاعتراضات التي أثارها محامو الخصوصية.

لكن لم يعد يتم إخطار الوالدين

يختلف أمان الاتصالات عن اكتشاف صورة CSAM. هذا يمسح صور iCloud للمستخدم ويشير إلى المحتوى الذي يسيء إلى وسطاء Apple.

تسببت هذه الميزة في احتجاج محامي الخصوصية. هناك أيضًا تحديث قادم لـ Siri Search مصمم لتقديم موارد إذا كان المستخدم يبحث عن مواضيع تتعلق بالاعتداء الجنسي على الأطفال.

ليس من الواضح حاليًا متى يتم التخطيط لإصدار هاتين الميزتين. لم تكن هناك تقارير تظهر في برنامج آبل التجريبي العام.

تجدر الإشارة إلى أن الميزات المضافة إلى أحدث إصدار تجريبي من iOS 15.2 قد تتغير بشكل ملحوظ قبل إصدارها الرسمي. يمكن إزالته بالكامل من التحديث.

تشمل الميزات الجديدة الأخرى التي وصلت في أحدث إصدار تجريبي ميزة حذف AirTag يدويًا. بالإضافة إلى خيار تمرير بيانات iCloud إلى أحد أفراد أسرته في حالة وفاتك.