مع الأسئلة الشائعة الجديدة ، حاولت Apple تهدئة المخاوف من أن إجراءاتها الجديدة لمكافحة إساءة معاملة الأطفال يمكن أن تتحول إلى أدوات مراقبة من قبل الحكومات الاستبدادية.

كتبت الشركة: “تقتصر هذه التقنية على اكتشاف مواد CSAM المخزنة في iCloud”. نحن لا نقبل أي طلبات حكومية لتوسيعه.

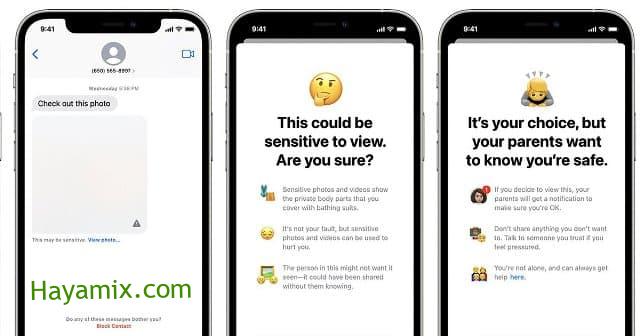

تشتمل الأدوات الجديدة للشركة على ميزتين مصممتين للمساعدة في حماية الأطفال:

- الأول هو ميزة أمان الاتصالات التي تستخدم التعلم الآلي على الجهاز لاكتشاف وإخفاء الصور الجنسية الصريحة التي يتلقاها الأطفال في تطبيق الرسائل. يمكنهم إخطار الوالد إذا قرر طفل يبلغ من العمر 12 عامًا أو أقل عرض هذه الصورة أو إرسالها.

- والثاني هو ميزة مصممة لاكتشاف مواد الاعتداء الجنسي على الأطفال عن طريق مسح صور المستخدم إذا اختاروا تحميلها عبر iCloud. يتم إخطار الشركة إذا تم العثور على مواد اعتداء جنسي على الأطفال. وهذا بدوره ينبه السلطات عند التحقق من وجود هذه المواد.

قوبلت هذه الخطط بردود سريعة من مجموعات الخصوصية الرقمية والناشطين. الذي ادعى تقديم ثغرة في برمجيات الشركة.

تقترح هذه المجموعات أنه في حالة وجود مثل هذا الباب الخلفي ، فمن الممكن دائمًا توسيعه للعثور على أنواع المحتوى التي تتجاوز مواد الاعتداء الجنسي على الأطفال.

ويمكن للحكومات الاستبدادية استخدامه للبحث عن المواد المعارضة سياسياً. حتى الباب الخلفي الضيق الموثق بعناية والذي تم بحثه بدقة لا يزال بابًا خلفيًا ، كما تكتب مؤسسة Electronic Frontier Foundation.

وأضافت: “تم إعادة توظيف إحدى التقنيات المصممة أصلاً لعرض وتجزئة صور الاعتداء الجنسي على الأطفال لإنشاء قاعدة بيانات للمحتوى الإرهابي يمكن للشركات المشاركة الوصول إليها لحظر مثل هذا المحتوى”.

ومع ذلك ، يدعي صانع iPhone أن لديه احتياطات لضمان عدم استخدام أنظمته للكشف عن أي شيء آخر غير صور الاعتداء الجنسي.

تدافع Apple عن نهجها في منع إساءة معاملة الأطفال

وتقول إن قائمة الصور المحظورة مقدمة من المركز الوطني للأطفال المفقودين والمستغلين (NCMEC) ومنظمات سلامة الأطفال الأخرى. يعمل النظام فقط مع تجزئات صور CSAM المقدمة من NCMEC ومنظمات سلامة الأطفال الأخرى.

وأوضحت أنها لن تضيف تجزئات الصور إلى هذه القائمة. وهذه القائمة هي نفسها لجميع أجهزة iPhone و iPad لمنع الاستهداف الفردي للمستخدمين.

وأشارت الشركة إلى أنها ترفض الطلبات الحكومية لإضافة صور غير CSAM إلى القائمة. وقالت: “لقد واجهنا مطالب بتغييرات فرضتها الحكومة تقوض خصوصية المستخدم من قبل ، وقد رفضنا باستمرار هذه المطالب”. سوف نستمر في التخلي عنها في المستقبل.

جدير بالذكر أنه على الرغم من تأكيدات شركة آبل ، إلا أنها قدمت تنازلات للحكومات في الماضي لمواصلة العمل في بلدانها.

تُباع أجهزة iPhone التي لا تحتوي على FaceTime في البلدان التي لا يُسمح فيها بإجراء مكالمات هاتفية مشفرة. في الصين ، أزال آلاف التطبيقات من متجر التطبيقات الخاص به. كما تنقل بيانات المستخدم إلى خوادم الاتصالات الحكومية.

ولم تتمكن الشركة من معالجة بعض المشكلات المتعلقة بالميزة التي تتحقق من الرسائل بحثًا عن مواد جنسية صريحة.

تنص على أن هذه الميزة لا تشارك أي معلومات مع Apple أو تطبيق القانون. لكنه لا يشرح كيفية الاحتفاظ بالأداة على الصور الجنسية الصريحة فقط.

كل ما يتطلبه الأمر لتوسيع الباب الخلفي الضيق هو توسيع خيارات التعلم الآلي للبحث عن أنواع محتويات إضافية ، أو تغيير علامات الإعداد لفحص حسابات شخص ما ، وليس الأطفال فقط ، كما كتبت مؤسسة Electronic Frontier Foundation.