أجلت شركة آبل ميزات حماية الطفل التي أعلنت عنها الشهر الماضي ، بما في ذلك ميزة مثيرة للجدل ستقوم بمسح صور المستخدمين بحثًا عن CSAM ، بعد انتقادات لاذعة بأن التغييرات قد تقلل من خصوصية المستخدم.

كان من المقرر تنفيذ التغييرات في وقت لاحق من هذا العام. وقالت الشركة في بيان: “أعلنا الشهر الماضي عن خطط لإنشاء ميزات للمساعدة في حماية الأطفال من الحيوانات المفترسة باستخدام الاتصالات لاستغلالهم والحد من انتشار مواد الاعتداء الجنسي على الأطفال”.

“بناءً على التعليقات الواردة من العملاء ومجموعات المناصرة والباحثين وغيرهم ، قررنا تخصيص وقت إضافي في الأشهر المقبلة لجمع المعلومات وإجراء التحسينات قبل إطلاق ميزات سلامة الأطفال المهمة هذه.”

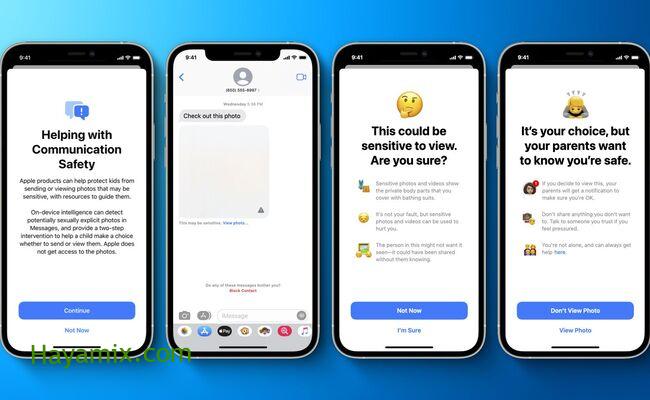

يوضح هذا الإصدار ثلاثة تغييرات رئيسية في الأعمال. تغيير واحد للبحث ، ويمكن لـ Siri الإشارة إلى الموارد لحظر CSAM إذا كان المستخدم يبحث عن معلومات عنها.

تم استكشاف التغييرين الأخريين بشكل أكبر. يمكن أن ينبه أحد التغييرات الآباء عندما يتلقى أطفالهم أو يرسلون صورًا جنسية صريحة تشوش صور الأطفال.

آبل تؤجل ميزات حماية الطفل المثيرة للجدل

تغيير آخر هو مسح الصور المخزنة في صور iCloud للمستخدم بحثًا عن مواد CSAM وإبلاغ مسؤولي الشركة ، الذين يمكنهم بعد ذلك إعادة توجيه التقارير إلى المركز الوطني للأطفال المفقودين والمستغلين أو NCMEC.

قامت الشركة بتفصيل نظام مسح الصور على iCloud لإثبات أنه لا يعرض خصوصية المستخدمين للخطر. باختصار ، يقوم النظام بمسح الصور المخزنة في iCloud Photos من خلال جهاز iOS. يقوم بتقييم هذه الصور جنبًا إلى جنب مع قاعدة بيانات لتجزئة صور CSAM الشهيرة من NCMEC وغيرها من منظمات سلامة الأطفال.

ومع ذلك ، انتقد العديد من خبراء الخصوصية الشركة بشدة بسبب النظام الجديد. يتم ذلك بحجة أنه يمكن تركيب نظام مراقبة داخل الجهاز. كما أنه يكسر ثقة المستخدمين في الشركة لحماية الخصوصية على الجهاز.

قالت مؤسسة الحدود الإلكترونية في بيان يوم 5 أغسطس / آب إن النظام الجديد يخالف الوعود الرئيسية بشأن التشفير الخاص ببرنامج المراسلة ويفتح الباب أمام انتهاكات أوسع.