إنه يفكر في حظر استخدام الذكاء الاصطناعي لمجموعة من الأغراض ، بما في ذلك المراقبة الجماعية وتقييم الائتمان الاجتماعي.

يتماشى هذا مع اقتراح تم تسريبه تم تداوله على الإنترنت ، نشرته بوليتيكو لأول مرة قبل إعلان رسمي متوقع الأسبوع المقبل.

إذا تم تمرير مسودة الاقتراح ، فقد يفرض الاتحاد الأوروبي موقفًا صارمًا بشأن تطبيقات معينة للذكاء الاصطناعي ، مما يميزه عن الولايات المتحدة والصين.

يتم تتبع حالات استخدام معينة بطريقة مشابهة لسياسة الخصوصية الرقمية الخاصة بالاتحاد الأوروبي بموجب تشريعات القانون العام لحماية البيانات (GDPR).

قد تحتاج الدول الأعضاء إلى إنشاء لوحة نتائج لاختبار والتحقق من صحة أنظمة الذكاء الاصطناعي عالية المخاطر.

يمكن تغريم الشركات التي تطور أو تبيع برمجيات الذكاء الاصطناعي المحظورة في الاتحاد الأوروبي ، بما في ذلك في أي مكان آخر في العالم ، حتى 4٪ من إيراداتها العالمية.

يتضمن مشروع القرار ما يلي:

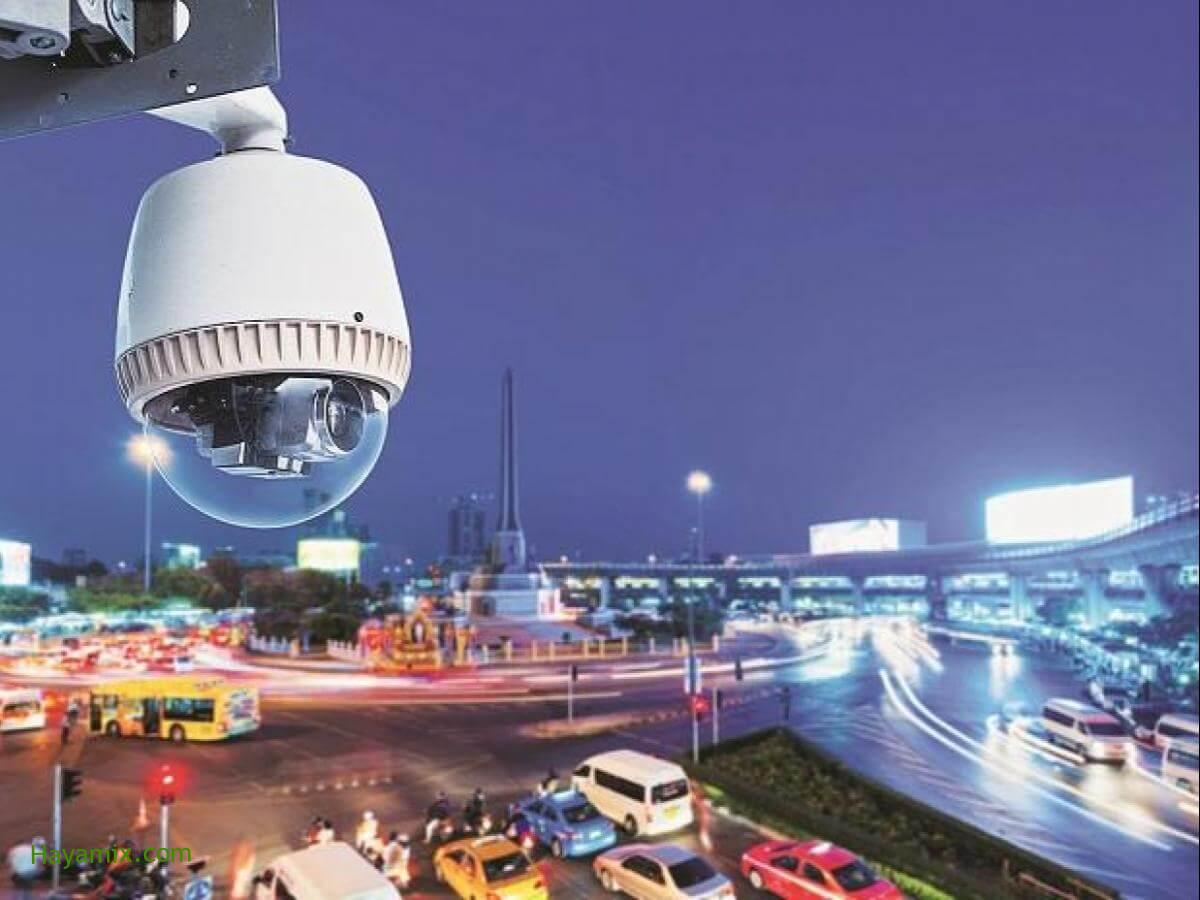

- تمنع أنظمة الاستخبارات المراقبة العرضية ، بما في ذلك الأنظمة التي تتعقب الأشخاص مباشرةً في البيئة المادية أو تجمع البيانات من مصادر أخرى.

- تحظر أنظمة الذكاء التي تولد تصنيفات ائتمانية اجتماعية ، مما يعني تقييم جدارة شخص ما بالثقة بناءً على السلوك الاجتماعي أو السمات الشخصية المتوقعة.

- إذن خاص لاستخدام الأنظمة الذكية للتعرف عن بعد ، على سبيل المثال ، التعرف على الوجوه في الأماكن العامة.

- الإخطارات مطلوبة عندما يتفاعل الأشخاص مع الأنظمة الذكية إذا لم يكن ذلك واضحًا من ظروف الاستخدام وسياقه.

- إشراف جديد على الأنظمة الذكية عالية الخطورة ، بما في ذلك تلك التي تشكل تهديدًا أمنيًا مباشرًا ، مثل السيارات ذاتية القيادة ، وتلك التي لديها فرصة كبيرة للتأثير على معيشة شخص ما ، مثل تلك المستخدمة في التوظيف ، وقرارات المحكمة ، والتاريخ الائتماني .

- تقييم الأنظمة الذكية عالية المخاطر قبل بدء التشغيل ، بما في ذلك ضمان قدرة المديرين التنفيذيين البشريين على تفسير هذه الأنظمة وتدريبها على مجموعات بيانات عالية الجودة ومُختبرة التحيز.

- إنشاء مجلس أوروبي للذكاء الاصطناعي ، يتألف من ممثلين من كل دولة ، لمساعدة اللجنة على تحديد الأنظمة الذكية التي تعتبر عالية الخطورة والتوصية بتغييرات على الحظر.